在数字化转型的浪潮中,企业对于高效、可扩展且成本效益高的IT基础设施需求日益增长,云服务器作为云计算的核心组成部分,凭借其弹性伸缩、资源高效利用等优势,成为了众多企业构建网络应用的首选,本文将深入探讨如何使用一组云服务器搭建多个网站,并同时实现负载均衡,以优化资源分配,提升用户体验,确保服务稳定性与安全性。

云服之家,国内最专业的云服务器虚拟主机域名商家信息平台

云服务器概述

云服务器(Cloud Server)是基于云计算技术,通过网络提供计算服务的一种虚拟服务器,与传统的物理服务器相比,云服务器具有更高的灵活性、可扩展性和成本效益,用户可以根据实际需求动态调整资源,如CPU、内存、存储空间等,而无需担心硬件采购、维护等成本,云服务商提供的全球分布节点,还能有效缩短访问延迟,提升服务响应速度。

多网站搭建的可行性

在云服务器上搭建多个网站是完全可行的,云服务器可以配置多个IP地址或域名,每个IP/域名可以指向不同的网站或应用,通过配置Web服务器(如Apache、Nginx)的虚拟主机功能,可以轻松实现不同域名对应不同的网站目录,从而实现多网站共存,利用容器化技术(如Docker)和微服务架构,可以进一步实现应用的解耦与高效管理。

负载均衡的重要性

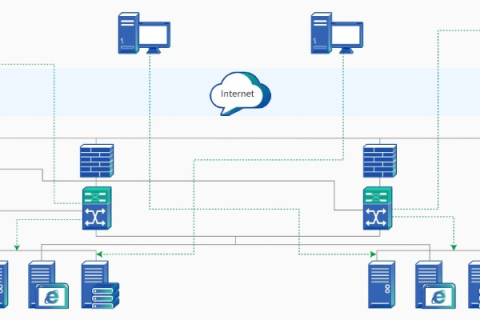

随着网站访问量的增加,单一服务器可能面临性能瓶颈和安全隐患,负载均衡(Load Balancing)技术通过将网络请求分发到多个服务器上,有效分散了服务器的压力,提高了系统的稳定性和处理能力,对于多网站部署而言,负载均衡尤为重要,它不仅能提升单个网站的访问速度,还能确保所有网站都能获得均衡的资源分配,避免因资源争夺导致的服务中断或性能下降。

实现负载均衡的方法

-

硬件负载均衡:使用专门的负载均衡设备(如F5 Big-IP、Cisco ACE),这些设备能够基于网络层进行流量分配,支持多种协议和应用场景。

-

软件负载均衡:通过软件(如Nginx、HAProxy)实现负载均衡,这类方法成本更低,配置灵活,适合大多数中小规模应用,Nginx凭借其强大的反向代理功能和高并发处理能力,成为许多开发者的首选。

-

云服务提供商的负载均衡服务:如AWS的Elastic Load Balancing(ELB)、Azure的Traffic Manager等,这些服务提供了高度自动化、可扩展的负载均衡解决方案,支持全球范围内的流量分发,降低了运维复杂度。

实施步骤与最佳实践

-

规划资源:根据各网站预期的访问量、资源需求合理规划云服务器的CPU、内存、带宽等资源。

-

配置Web服务器:在云服务器上安装并配置Nginx或Apache等Web服务器软件,设置虚拟主机以区分不同网站。

-

部署应用:利用Docker等容器技术将应用打包部署到云服务器上,实现应用的快速部署与扩展。

-

启用负载均衡:根据选择的负载均衡方式,配置相应的负载均衡规则,确保请求被均匀分配到各个服务器实例上。

-

监控与优化:利用云服务提供的监控工具(如AWS CloudWatch、Azure Monitor)持续监控服务器性能,根据负载情况动态调整资源分配或增加服务器实例。

-

安全考虑:实施SSL证书加密、防火墙规则等安全措施,保护网站免受DDoS攻击、SQL注入等安全威胁。

案例研究

以某电商平台为例,该平台拥有多个品牌子站,每个子站需独立运营但共享部分基础设施,通过采用AWS云服务,该平台成功在一组EC2实例上搭建了所有子站,并利用AWS Application Load Balancer实现了全局负载均衡,通过智能路由和自动扩展功能,平台能够根据访问量自动调整服务器资源,有效降低了运营成本并提升了用户体验,借助AWS Shield和WAF服务,增强了平台的安全性。

利用一组云服务器搭建多个网站并实现负载均衡,是提升企业IT效率、降低成本、增强服务稳定性的有效策略,通过合理规划资源、选择合适的负载均衡方案以及持续监控与优化,企业可以构建出既高效又安全的多站点网络环境,随着云计算技术的不断演进,未来在云上构建复杂应用将变得更加简单高效,为企业数字化转型提供坚实的技术支撑。